在人工智能和机器学习技术迅速发展的当下,微调大型语言模型成为提高模型适应性和精确度的重要手段。然而,进行这项工作并非没有门槛,正确的电脑配置和优化措施是成功微调大模型的关键所在。本文将详细探讨进行微调所需的基础电脑配置以及如何进行配置优化,为想要涉足这一领域的读者提供全面的指导。

确定基础电脑配置

要微调大型模型,首先需要确保你的电脑满足一定的硬件条件。以下是几个核心硬件的配置建议:

CPU

CPU(中央处理单元)是微调大型模型不可或缺的重要组件。高端CPU能提供更好的并行处理能力,对加速计算流程至关重要。建议至少选择具有多核心(如8核以上)、高频率(3.0GHz以上)的处理器。

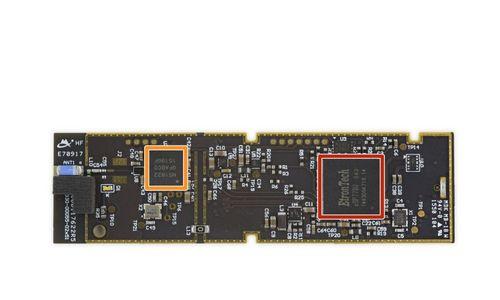

GPU

对于深度学习任务,拥有足够强大的GPU(图形处理单元)至关重要。GPU有助于加速大规模数据的矩阵运算。选择NVIDIA的GPU会是更佳的选择,因为它们通常有更好的运行深度学习框架的支持。至少选择具有6GB以上显存的GPU,例如NVIDIAGTX1060或者更高级别。

内存

内存是支撑CPU和GPU进行大量数据处理的重要组成部分。在微调大型模型时,内存的需求一般在16GB至32GB之间,对于更复杂的任务甚至需要更高的内存。

存储

SSD(固态硬盘)是推荐的存储设备。大型模型及其数据集的加载和读写非常依赖于高速IO性能。至少需要256GB的SSD,如果预算允许可选择更高容量以获得更好的性能和存储空间。

如何优化配置

在具备了基础配置之后,接下来是如何在这基础上进行优化来提升微调的效率和效果。

操作系统和驱动程序

确保操作系统是最新的,并且安装了与你的硬件兼容的最新驱动程序。特别是GPU驱动程序,正确安装并及时更新可以避免在计算过程中遇到潜在的问题。

软件依赖

安装并配置好深度学习框架,如TensorFlow或PyTorch。确保安装了所需的库和依赖包。使用虚拟环境来隔离不同的项目依赖,可以避免包之间的冲突。

系统调优

关闭不必要的后台程序和服务,减少内存和CPU的占用。

调整系统的虚拟内存设置,根据实际需求合理配置。

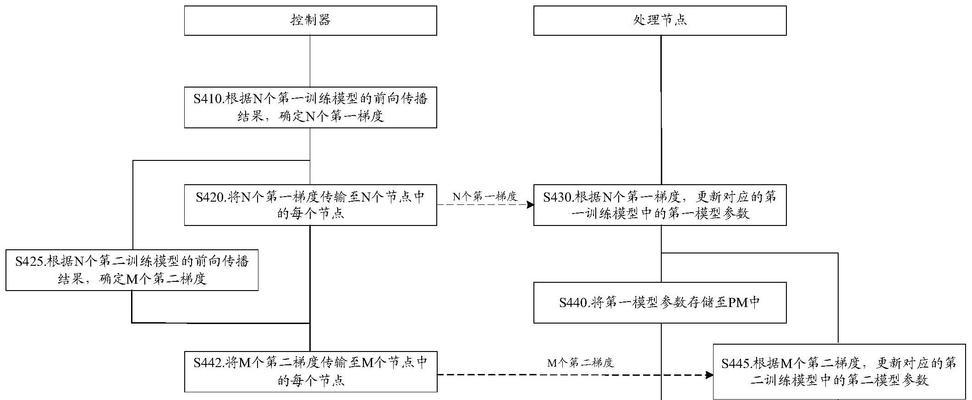

考虑使用高性能计算集群,如果单机配置不足以满足需求,集群计算可以提供必要的计算资源。

数据管理

将数据集存储在高速驱动器上,并考虑使用数据加速加载技术,如使用NFS或分布式文件系统。

在数据处理阶段,对数据进行预处理和划分,以减少运行时的I/O开销。

结语

在微调大型模型时,合适的电脑配置和正确的优化方法对提升效率、确保任务顺利完成起着至关重要的作用。通过上述指导,您应该能够理解进行大模型微调需要的基本硬件条件及如何进行合理的配置优化。按照这些步骤,您将能更好地准备自己的计算环境,并高效地开展微调工作。

现在,无论是进行微调的前期准备还是后期优化,您都已经具备了足够的知识和技巧。只要按照本文的建议进行操作,您一定可以在人工智能的探索之路上迈出坚实的步伐。