随着人工智能技术的飞速发展,大模型在语言处理、图像识别等多个领域展现出强大的能力。然而,不少用户对于如何在低配置电脑上使用这些先进的大模型存在疑惑。本文将详细解答低配置电脑如何使用大模型,同时指导大家如何解决可能遇到的兼容性问题。

如何在低配置电脑上使用大模型

核心硬件要求

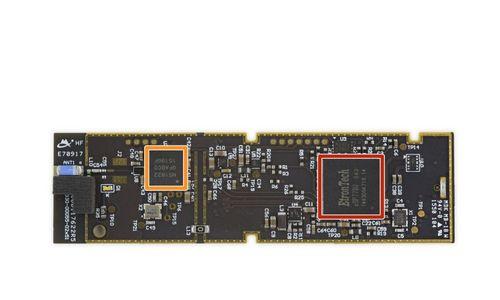

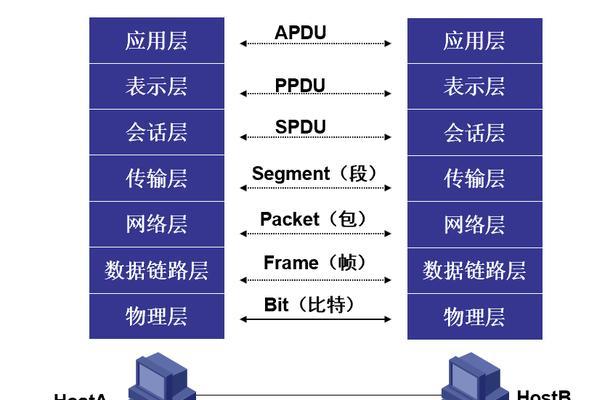

在踏上使用大模型的征途之前,我们需要对基本的硬件要求有所了解。通常,运行大模型需要一定的计算资源,包括足够的RAM和较新的CPU/GPU。但以下一些策略可以帮助低配置电脑用户:

1.使用轻量级模型:选择在训练时进行了模型简化或压缩的版本,尽管性能略有损失,但在低配置电脑上可以实现较好的运行效果。

2.优化模型加速库:利用TensorRT、ONNXRuntime等优化后的深度学习库,可以在不显著牺牲性能的情况下加速推理过程。

操作系统与环境的配置

即使在低配置电脑上,正确配置操作系统和模型运行环境也是至关重要的。

1.操作系统升级:尽可能保持操作系统更新到最新版本,新的系统版本往往包含了性能优化和兼容性改进。

2.安装适当的深度学习框架:TensorFlow、PyTorch等深度学习框架都提供了对低配置设备的支持。选择适合您设备的框架版本,尽量利用硬件加速功能。

精简模型参数

在低配置电脑上,我们可以采取以下措施减轻模型对硬件的压力:

1.裁剪模型参数:通过去除一些冗余的神经网络结构或参数,达到减少内存占用和计算量的目的。

2.量化和知识蒸馏:量化可以将模型参数从浮点数转换为低精度的表示形式,减少计算复杂度;知识蒸馏则是一种模型压缩技术,通过较小的模型来模仿大模型的性能。

使用云资源

对于资源受限的用户,使用云计算资源进行大模型的训练和推理是一个有效的选择:

1.云服务提供商:选择如阿里云、腾讯云等服务商提供的GPU计算资源,这些资源可以临时租用,按需付费。

2.利用容器化技术:Docker等容器化技术可以帮助您在云上快速部署和运行预设的环境及模型。

兼容性问题的解决方法

兼容性问题是很多低配置电脑用户在使用大模型时头疼的问题。以下是一些解决策略:

依赖库的更新与兼容

1.跟踪依赖库的版本更新:确保你的所有深度学习库及其依赖项都是最新版本,并且与你的操作系统兼容。

2.使用虚拟环境:利用Python的virtualenv或conda等工具创建独立的运行环境,可以有效管理不同项目的依赖关系,避免冲突。

软件兼容性配置

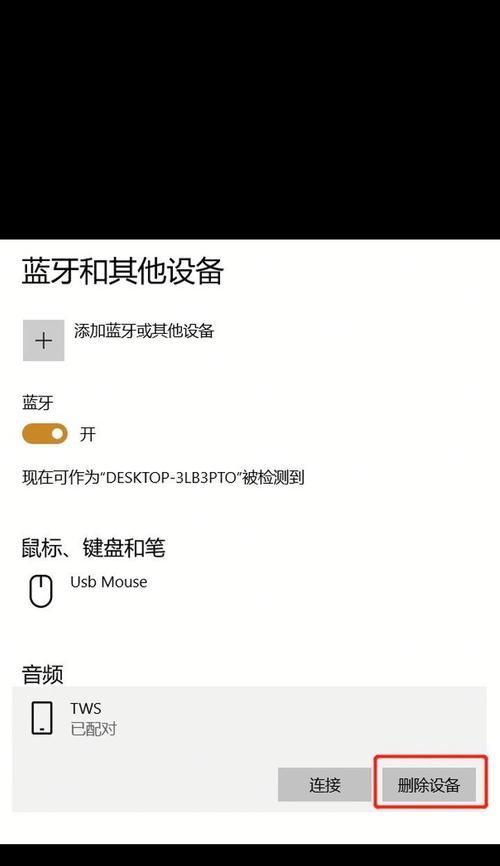

1.驱动程序更新:确保所有的硬件驱动程序,特别是显卡驱动程序,是最新版本,以保持最佳的兼容性和性能。

2.系统兼容性设置:通过调整操作系统自带的兼容性设置来运行一些老旧的软件或库。

问题排查与解决

1.日志分析:当遇到兼容性问题时,仔细查看软件运行时的错误日志,这可以提供关键的线索来定位问题所在。

2.寻求帮助:在官方文档、技术社区、论坛等处寻求帮助。其他开发者或专家可能已经遇到并解决了类似问题。

通过上述的指导和建议,即使是资源有限的低配置电脑用户也能够成功地使用大模型,并且大幅减少因兼容性问题带来的困扰。当然,实现这一目标需要用户具备一定的技术背景,并且愿意进行学习和尝试。在实践中,不断优化和调整使用策略是成功运用大模型的关键。

以上步骤和技巧旨在为那些希望在有限的硬件条件下探索人工智能大模型的用户提供建议。随着技术的不断进步,也许不久的将来能够在更低配置的设备上流畅地使用这些强大的工具。通过本文的详尽指导,相信您已经对如何让低配置电脑与大模型兼容有了更加深入的理解。